自分の研究の論文が出版されたので、簡単に紹介。

Vertical partitioning of freshwater bacterioplankton community in a deep mesotrophic lake with a fully oxygenated hypolimnion (Lake Biwa, Japan) - Okazaki - 2016 - Environmental Microbiology Reports - Wiley Online Library

一言でいえば

琵琶湖の水中で季節・深さごとに出現する細菌を網羅した図鑑を作成

3行で言えば

・琵琶湖沖で15か月・3水深にわたって、水中の細菌群集を網羅的に調査

・特に、研究例が少ない、深層に生息する細菌に注目

・深層にのみ生息する、10以上の「変わった系統」の細菌を特定

という内容。

研究する意味

「琵琶湖の細菌の研究なんてもうやりつくされているんじゃないの?」と思われそうだけど、実はまだほとんど何もわかっていない。単に研究者がいなかった、というのも大きな理由だけど、やはり一番大きな障壁は、

ほとんどの細菌は培養ができないので、研究もできない

ということだ。

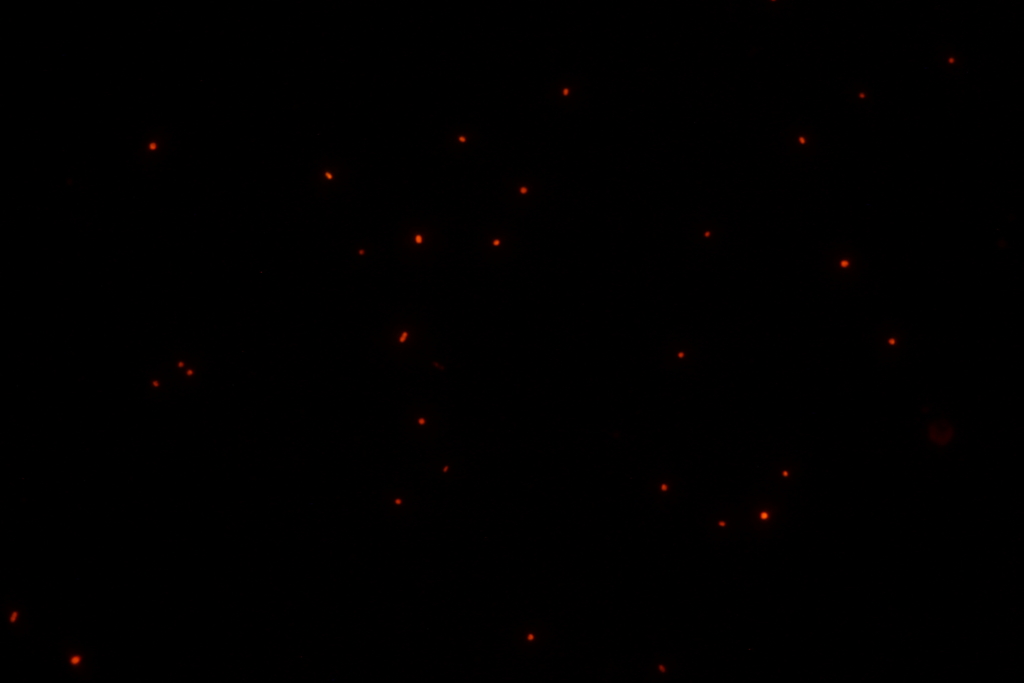

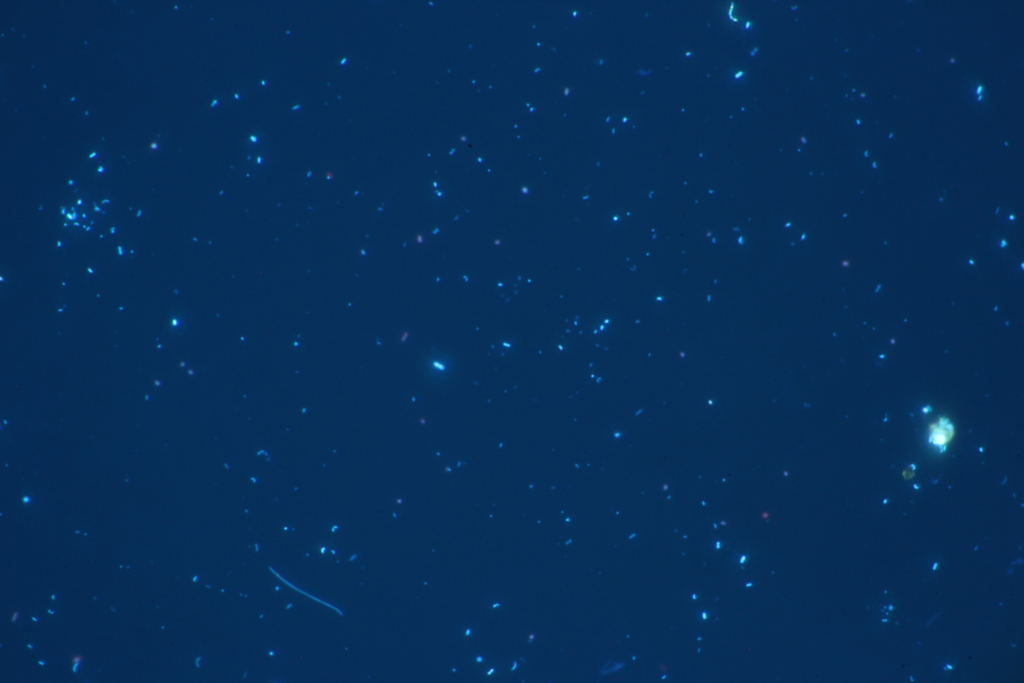

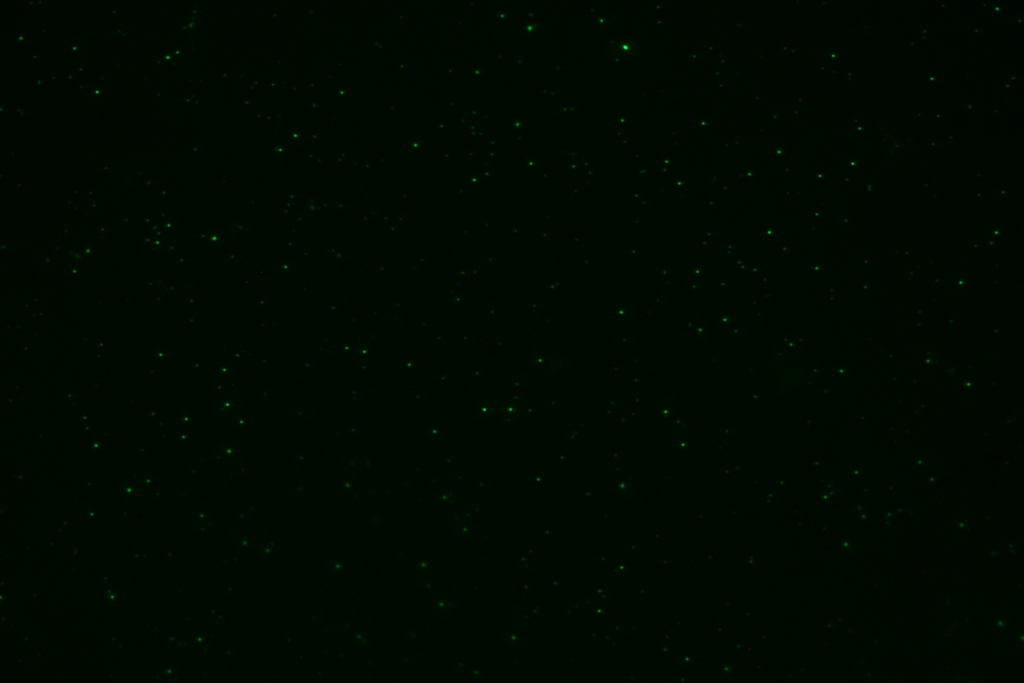

琵琶湖の水中には1ml(ティースプーン1杯)あたり100万を超える細菌が生息している。顕微鏡でみれば、それこそ星の数ほどの細菌が見られる。

だけど、環境中にはこんなにたくさんいるのに、なぜか研究室に持ち帰って人工的な環境で飼おうとすると、ほとんどの細菌は増えてくれない(正確には、少数の増えやすい奴ばかり増えてしまう)。その理由はまだよく分かっていない。人工的な環境では再現できないような、環境中に存在する絶妙な何かが欠けているのだろう。で、培養ができなければ、個々の細菌系統の性質を詳しく調べることもできない。だから、難培養の細菌系統を培養する、というのは大仕事で、日夜多くの研究者たちがリソースを割いているし、重要な系統を単離することに成功すれば、それだけでNatureに掲載されるレベルのインパクトを世界に与えることができる。

琵琶湖の細菌も例外ではなく、細菌全体の存在数やその季節変動を報告した研究は昔から例があったものの、培養できないことが障壁となって、「どのような系統が生息しているか」ということは解明されずにいた。

そこに訪れた大きな転機が「次世代シーケンサー(NGS)」の登場だ。簡単に言えば、環境中に存在するDNAを集めてきて、片っ端から塩基配列を読むことで、どの遺伝子を持った細菌がどれくらいいるかを、培養することなしに推定することができる技術だ。細菌の系統は特定の遺伝子(16S rRNA遺伝子)の塩基配列を元に分類でき、データベースに情報が蓄積されている。だから、この遺伝子の塩基配列の情報さえ手に入れば、それが培養できない系統であっても、どのような分類に属し、過去にどのような環境で見つかってきたものなのかは分かる。

このNGSの登場は本当に革命的で、水中に限らず、あらゆる環境に生息する細菌の生態が急速に明らかになりつつある。微生物学者にとっては「ボーナスステージ」と言っていいような状況で、様々な動物の腸内、家のドアや電車のつり革、歴史的絵画の表面に至るまで、調べれば調べるだけ新しい発見が出てくる事態で、論文もバンバン出版されている状況だ。

その一方で、「NGSを使ってまだ調べられていない環境の細菌の組成を調べました、おしまい」というだけの、単なる記載的な研究が増えているという批判があるのも事実だ。

新しいところを調べれば、新しいものが出てくるのは当たり前。それが何を意味しているのか、どう面白いのかが肝要だ

という流れになりつつあるというのが、NGS技術が一通り普及しきった今の業界の状況だ。

何をしたのか?

このNGSを琵琶湖で初めて使い、どのような細菌が生息するのかを網羅したのがこの研究だ。だけど、単に表層の水を採って細菌群集を調べるだけの研究であれば、すでに世界中の湖沼で行われている研究の二番煎じになってしまう。

そんな中で、本研究は、

①これまでに研究が行われてこなかった、深層に焦点を当てたこと

②15か月にわたる継続的な調査を行い、季節変動を明らかにしたこと

という二点を大きなウリにしている。

特に①の「大型淡水湖の深層にはどのような細菌が生息しているのか」ということに関しては、世界的にもほとんど報告が無い。手掛かりになるような断片的な情報は存在するものの、NGSで季節変化を含めて網羅した研究は、本研究が初めてになる。そのような意味で、本研究は

湖の深層に生息する細菌の組成を、世界で初めて網羅的にみる

のが目的と言える。

何が分かったのか?

過去に琵琶湖沖に毎月通って採り溜めていた3水深×15か月のDNAサンプルを使って、NGSで16S rRNA遺伝子のシーケンスを行い、とれてきた塩基配列をもとに各サンプルの細菌群集を分析した。すると、表層と深層では生息する細菌系統が大きく異なることが分かった。しかも、これまで表層で良く知られている細菌とは、「門」のレベル(一番大きな生物の分類の区分)で異なる系統が深層にたくさん生息していることが分かった。

これらの系統の塩基配列をDNAのデータベースで調べてみると、実はすでに、世界中の深い湖からの報告が散発的に存在することが分かった。このことから、これらの系統は、琵琶湖にだけ生息するのではなく、世界中の湖の深水層に普遍的に生息する系統であると考えられる。

本研究では、これらの過去に報告されてきた知見をまとめながら、琵琶湖で季節・深度ごとに採られたデータを加えて、湖沼の深水層に生息する細菌系統を初めて網羅的に整理することができた。

何がすごいのか?今後の発展は?

湖の深層に生息する細菌は、湖全体の物質循環や生態系の中で重要な役割を果たしている。本研究が「深層には表層とは全く違う系統が生息している」ことを明らかにしたことで、今後これらの深層独自の細菌系統の生態の解明を進めていかなければならないことが分かった。

ただ、「じゃあ彼らは生態系内でどのような役割を果たしているのか?」とことについては、現時点では分からない。今回見つかった「門」の多くは、多数の難培養性系統で構成される、ほとんど正体が分かっていない分類群だからだ。残念ながら本研究は「変なのがたくさんいるからもっと研究を進めましょう」というところで終わってしまっている。

なので、今後は今回明らかにした個々の細菌系統に焦点を当て、どのような遺伝子や代謝活性を持っているか調べて、彼らが生態系で何をしているのか、なぜそこにたくさんいるのか、ということを明らかにしていく必要がある。

また、今回は琵琶湖のみでの調査だったけど、データベースの情報などから、他の湖にも似たような系統が存在している可能性が高い。今回琵琶湖で見つかった発見が、どの程度一般化できる内容なのか、今後調査地の数を増やして検討していく必要がある。

前者については、データをとり始めており、後者についてはすでに結果が出揃って、論文の執筆に着手しているところだ。

また、さらに長い目で見たとき、僕はこの湖の深層の細菌の研究を、単なる湖の生態学の研究で終わらせずに、「生物学の新発見の宝庫」に育て上げたいと思っている。断言できる根拠はないけれど、環境の特殊性や、調査の容易さ、出現する細菌系統の異質さなどを考えると、この環境を深堀りしまくることで、生態学や微生物学、もしかすると生命科学全般に影響を及ぼすような、面白い現象を発見できるのではないか、という気がしている。本研究は、人生を賭けるその長い道のりの、最初の出発点となる予定の研究だ。

ここに至るまで

しかし、長かった。会社を辞めて研究に戻ってきてから、1年以上アウトプットが無かったことがとてもストレスだった。ライバルが似たような研究をしているのも知っていたし、何よりも「色々やっているのにまだ何も成果になっていない」ということが悔しくて、この1年少し、早く論文を出したい一心だった。

本研究は、去年の4月、研究に戻ってきた直後に思いついて、修士課程の時に採り溜めていたサンプルを使ってすぐに着手した研究だ。「とりあえず論文1本出そう」くらいの気持ちで、そこからほぼ滞りなく、最速で進めてきたつもりだけど、

・4-5月 予備実験

・6-7月 シーケンス外注

・8-9月 結果分析、一部サンプルの失敗判明

・10-11月シーケンス再外注

・12月 分析

・1月 論文執筆⇒英文校閲

・2月 論文投稿⇒瞬殺リジェクト⇒すぐに再投稿

・3月 レビューコメント付きリジェクト(姉妹誌への投稿はOK)

・4月 リバイス⇒姉妹誌に投稿

・6月 マイナーリビジョン⇒すぐに再投稿⇒アクセプト

・7月 オンライン公開

という流れで、結局1年以上もかかってしまった。特に、初稿を書き終えた1月から、アクセプトまでに半年も待たされたことは、とてつもなくストレスだった(それでもかなり早いほうだと言われるけど)。また、2回目のリジェクトのあと、査読コメントに従って大幅に書き直しをすることになった4月は本当に苦しかった。一度書いたものを全て分析しなおして、書き直す大変さは並大抵ではない。初稿ができた段階で、8割くらい終わっているかと思ったけど、時間的にも労力的にも、初稿ができた段階でようやく半分くらいだなぁ、と思った。

会社員時代と同じ仕事スピードで大学院生をやれば、サクサク早く効率的にアウトプットが出せるだろうと思っていた頃もあった。だけどやっぱ研究は、厳密さが全然違うし、一人でやらなければならないから、必要な労力も時間も全然違う。種を撒いてから収穫まで、1年以上は余裕でかかる。だから、去年の秋に種を撒いて、今論文を書いているネタが公開されるのは来年になるだろうし、今種を撒いているやつが出荷されるのは再来年の春とかになるかもしれない。本当に気が遠くなるし、のろまだと思う。でも、しょうがない。ライバルもみんな同じだ。効率的に収穫できるように、できるだけ計画的に種まきをすすめるのみだ。

しかし、やっぱり、自分の仕事が自分の名前で論文になるのはとても嬉しい瞬間だ。一本目の論文が出た時も「これでいつ死んでも世の中に名前が残せる」みたいなことを思ったけど、またこの感動を味わえて嬉しい。研究に戻ってきてよかったです。

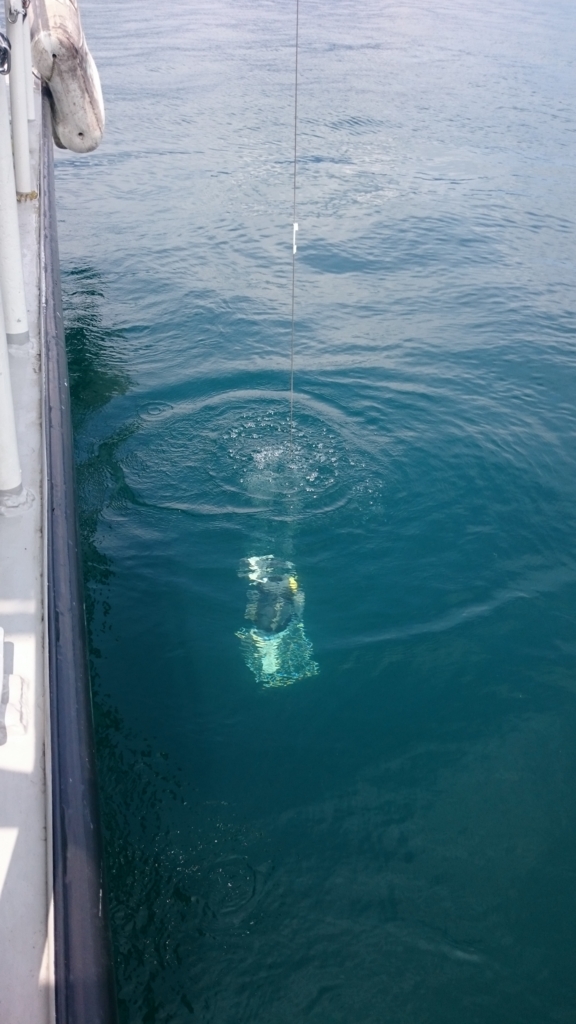

その一方で、北湖では水がますます透明になっている。少雨で川からの泥の粒子の流れ込みがないうえ、猛暑で温度躍層の発達が進んで、表層の栄養不足による植物プランクトンの減少がすすんでいるからだ。水深10 mまでが水温28℃以上、そこから水温が一気に下がって、水深20 mではもう13℃という状況。透明度は8.5 mで、採水器をおろしても外洋のように水が透き通っている。

その一方で、北湖では水がますます透明になっている。少雨で川からの泥の粒子の流れ込みがないうえ、猛暑で温度躍層の発達が進んで、表層の栄養不足による植物プランクトンの減少がすすんでいるからだ。水深10 mまでが水温28℃以上、そこから水温が一気に下がって、水深20 mではもう13℃という状況。透明度は8.5 mで、採水器をおろしても外洋のように水が透き通っている。